Carta :: 044 :: O Efeito DeepSeek

Quando menos é mais. E por que isso muda tudo.

Lembro exatamente onde estava quando vi a notícia.

Janeiro de 2025. Segunda-feira. Café esfriando na mesa de cabeceira. Abri o app de investimentos ainda na cama e vi vermelho em tudo que era chip. NVIDIA despencando 17%. Meu ETF de semicondutores sangrando.

Minha primeira reação foi culpar alguma notícia macro. Fed, China, sei lá.

Aí li o nome: DeepSeek.

Uma startup chinesa que eu mal conhecia tinha acabado de fazer a maior queda de valor de mercado da história americana acontecer. $589 bilhões evaporados. Em um único dia.

Quinhentos. E. Oitenta. E. Nove. Bilhões.

Confesso: fiquei paralisado por uns dez segundos. Não pela perda (temporária, como se provou). Mas pelo que aquilo significava.

Marc Andreessen chamou de “momento Sputnik da IA”. Jensen Huang, CEO da NVIDIA, disse que era “exatamente o oposto” do que o mercado pensou.

E eu fiquei me perguntando: o que diabos uma startup de Hangzhou fez para abalar os alicerces de uma indústria de trilhões?

Na Carta 003, escrevi sobre DeepSeek quando o R1 acabou de sair. Chamei de “o pequeno David que abalou o Golias”.

Meses depois, eles fizeram de novo. E de novo. E de novo.

Isso não é sorte. É estratégia.

O David que Calculou Diferente

A história começa com Liang Wenfeng.

Engenheiro nascido em 1985. Durante a crise de 2008, ainda estudante, começou a desenvolver sistemas de trading algorítmico. Em 2015, fundou o High-Flyer, um fundo quantitativo que chegou a administrar $12 bilhões.

O diferencial do High-Flyer sempre foi IA. Em 2017, a maioria das operações já era impulsionada por modelos de deep learning.

Isso importa porque explica a mentalidade.

Quem vem de trading quantitativo pensa em eficiência obsessiva. Cada milissegundo importa. Cada centavo de custo computacional importa. Você não joga dinheiro no problema, você otimiza até sangrar.

Em 2023, Liang criou a DeepSeek. Com uma premissa simples:

“O problema que enfrentamos nunca foi dinheiro. Foi o embargo de chips de alta performance.”

Quando você não pode ter os melhores chips, você precisa ser mais inteligente com os chips que tem.

E foi exatamente isso que fizeram.

O Número que Ninguém Acreditou

$5,6 milhões.

Esse foi o custo declarado para treinar o DeepSeek-V3, um modelo de 671 bilhões de parâmetros que rivalizava com GPT-4o e Claude 3.5 Sonnet.

Para comparação: estimativas para o GPT-4 variam de centenas de milhões a mais de $1 bilhão. Só em computação.

Claro que o número é enganoso. A DeepSeek tem aproximadamente 50.000 GPUs, investimento de cerca de $1,6 bilhão em infraestrutura. Tem anos de P&D em arquiteturas experimentais. Dario Amodei, CEO da Anthropic, estima que os custos reais se aproximam de $1 bilhão.

Mas mesmo assim.

Mesmo multiplicando por 100, a eficiência é absurda.

E a pergunta que ficou martelando: como?

O Framework da Eficiência Brutal

Depois de estudar o caso, identifiquei os pilares que explicam como a DeepSeek fez o que fez:

01 :: Arquitetura Inteligente (Mixture-of-Experts)

O modelo tem 671 bilhões de parâmetros. Mas só ativa 37 bilhões por vez.

Pensa assim: é como ter um time de 257 especialistas, mas só chamar 9 para cada tarefa. Os outros ficam dormindo.

Resultado? Fator de 28,6x. Você paga por 671 bilhões, mas só usa 37 bilhões de computação por inferência.

02 :: Compressão de Memória (Multi-Head Latent Attention)

Eles inventaram uma técnica que reduz o cache de memória em 93,3%.

Traduzindo: onde antes precisava de 100 GB de RAM, agora precisa de ~7 GB.

Isso significa janelas de contexto maiores sem explodir os custos.

03 :: Treinamento em Precisão FP8

Nenhum laboratório ocidental tinha validado treinamento em FP8 em modelos dessa magnitude.

A DeepSeek fez. Dobrou o throughput computacional. Reduziu requisitos de memória pela metade.

O padrão é sempre o mesmo: onde os outros jogavam mais hardware no problema, eles jogavam mais matemática.

O Paradoxo de Jevons em Ação

Jensen Huang foi o único que entendeu de primeira.

Enquanto o mercado entrava em pânico, “IA não precisa mais de chips!”, ele viu o oposto.

Paradoxo de Jevons: quando um recurso se torna mais eficiente, seu consumo total aumenta.

Aconteceu com carvão na Revolução Industrial. Com banda larga nos anos 2000. Vai acontecer com computação de IA.

Se rodar um modelo de fronteira custa 10x menos... a demanda não cai 10x. Ela explode 100x.

Porque agora quem não podia pagar, pode.

Uma startup brasileira que não tinha como gastar $100k/mês em API agora gasta $10k e compete.

Um estudante na Nigéria baixa o modelo e roda localmente.

Uma empresa média automatiza processos que antes só as Fortune 500 conseguiam.

Democratização não reduz o mercado. Expande exponencialmente.

Uma semana depois do crash, a NVIDIA já tinha recuperado quase tudo.

O Que Isso Significa Para Você

Três implicações práticas:

01 :: Open Source Virou Competitivo de Verdade

Até janeiro de 2025, modelos open-source eram “bons o suficiente para algumas coisas”.

Agora? DeepSeek-R1 empata com OpenAI o1 em raciocínio. 97,3% no MATH-500 contra 96,4% do o1.

E está disponível sob licença MIT. Totalmente permissivo para uso comercial.

Se você está pagando fortunas em APIs proprietárias sem avaliar alternativas open-source, está jogando dinheiro fora.

02 :: Eficiência Algorítmica > Escala Bruta

A era de “jogue mais GPUs no problema” está terminando.

Os próximos vencedores serão quem extrair mais de menos. Quem otimizar arquiteturas. Quem pensar em eficiência desde o design.

Isso vale para empresas de IA. Mas também para quem usa IA.

O prompt mais longo nem sempre é o melhor. O modelo maior nem sempre é o certo. O workflow mais caro nem sempre ganha.

03 :: A Janela de Oportunidade Está Aberta

Modelos de fronteira agora são commodity disponível para qualquer um.

A vantagem competitiva não é mais acesso à tecnologia. É o que você faz com ela.

Enquanto as big techs recalibram estratégias e despejam centenas de bilhões em infraestrutura, existe uma janela onde startups e profissionais ágeis podem capturar valor desproporcional.

Mas janelas fecham.

A Resposta das Big Techs

O “Efeito DeepSeek” forçou reações em cadeia:

:: OpenAI anunciou seus primeiros modelos open-weight desde GPT-2. Sam Altman admitiu estar “do lado errado da história” sobre código aberto.

:: Microsoft manteve $80 bilhões em capex para IA, mas Satya Nadella passou a ver OpenAI como “apenas um player”. Azure agora oferece DeepSeek.

:: Meta dobrou a aposta — $70 bilhões em capex 2025. Mark Zuckerberg promete “centenas de bilhões” em IA a longo prazo.

:: Google aumentou capex para $85 bilhões.

:: Amazon anunciou $100 bilhões — aumento de 51% ano a ano.

O projeto Stargate (joint venture de OpenAI, SoftBank e Oracle) promete $100 bilhões iniciais, potencialmente expandindo para $500 bilhões.

Me peguei calculando: são mais de $300 bilhões anunciados em resposta a uma startup que gastou $5,6 milhões.

Cem mil vezes mais capital.

A lição? DeepSeek não matou a demanda por infraestrutura. Acelerou.

Mas mudou quem pode jogar o jogo.

E a pergunta que não quer calar: eficiência pode ser copiada? Ou é mentalidade?

O Elefante Geopolítico

Não dá para ignorar o contexto.

O DeepSeek conseguiu resultados de fronteira usando chips que, em teoria, não deveria ter acesso. As sanções americanas limitam venda de GPUs de alta performance para a China.

Três homens foram acusados em Singapura por fraude ligada a movimentação de chips Nvidia para a DeepSeek. Malásia abriu investigação.

Um relatório do Comitê Seleto da Câmara americana intitulou seu documento de “DeepSeek Desmascarado”, afirmando que a empresa é “referenciada mais de 150 vezes em registros de aquisição do Exército de Libertação Popular da China.”

Não vou entrar no mérito político. Mas o fato é:

Sanções falharam em impedir inovação. Talvez tenham até acelerado, forçando engenhosidade onde haveria complacência.

A questão para os próximos anos: como democracias ocidentais vão equilibrar competição tecnológica com preocupações de segurança nacional?

Não tenho resposta. Só mais perguntas.

E Eles Fizeram De Novo

Enquanto escrevo esta carta, o DeepSeek acaba de lançar o v3.2.

E o padrão se repete.

DeepSeek v3.2 é oficialmente o primeiro modelo open-source a ganhar ouro na Olimpíada Internacional de Matemática. Batendo GPT-5 High e Gemini 3.0 Pro.

Os benchmarks são absurdos:

:: AIME 2025: GPT-5 High marcou 94,6%. Gemini 3.0 Pro marcou 95%. DeepSeek v3.2 Special? 96%.

:: LiveCodeBench: 88,7% na versão Special.

:: Medalha de ouro também na IOI (Olimpíada Internacional de Informática).

E como conseguiram? Três inovações que mostram que a filosofia não mudou:

01 :: DeepSeek Sparse Attention (DSA)

Atualizaram o mecanismo de atenção, aquele “attention is all you need” que é o coração dos transformers.

A complexidade caiu de O(L²) para O(L*K).

Traduzindo: antes, dobrar a janela de contexto quadruplicava o custo. Agora, dobrar a janela basicamente dobra o custo.

É a diferença entre custos que explodem e custos que você consegue controlar.

02 :: Reinforcement Learning Escalável

Investiram mais de 10% do budget de pré-treinamento em reinforcement learning. Parece pouco. Mas comparado a praticamente todos os modelos anteriores, é uma mudança de paradigma.

O resultado? Raciocínio no nível de GPT-5.

03 :: Síntese de Tarefas Agênticas

Para fazer o modelo bom em usar ferramentas, criaram 1.800 ambientes distintos e 85.000 prompts complexos de tarefas agênticas.

Dados sintéticos gerados especificamente para treinar uso de tools.

Quanto mais você remove humanos do processo de criação de IA, mais escalável fica.

O modelo mantém os 671 bilhões de parâmetros com 37 bilhões ativos. Licença MIT. Totalmente open-source.

A mensagem é clara: janeiro não foi acidente. É estratégia.

E a distância entre open-source e closed-source continua encolhendo.

A Verdade Inconveniente

Me peguei pensando naquele dia de janeiro.

O pânico inicial. O vermelho na tela. A sensação de que algo fundamental tinha mudado.

E tinha.

Mas não do jeito que o mercado pensou.

O “Efeito DeepSeek” não provou que IA é bolha. Provou que a corrida está só começando, e que os competidores são mais numerosos e mais criativos do que imaginávamos.

$589 bilhões evaporaram em um dia. E voltaram na semana seguinte.

Porque o mercado percebeu: eficiência não mata demanda. Eficiência cria demanda.

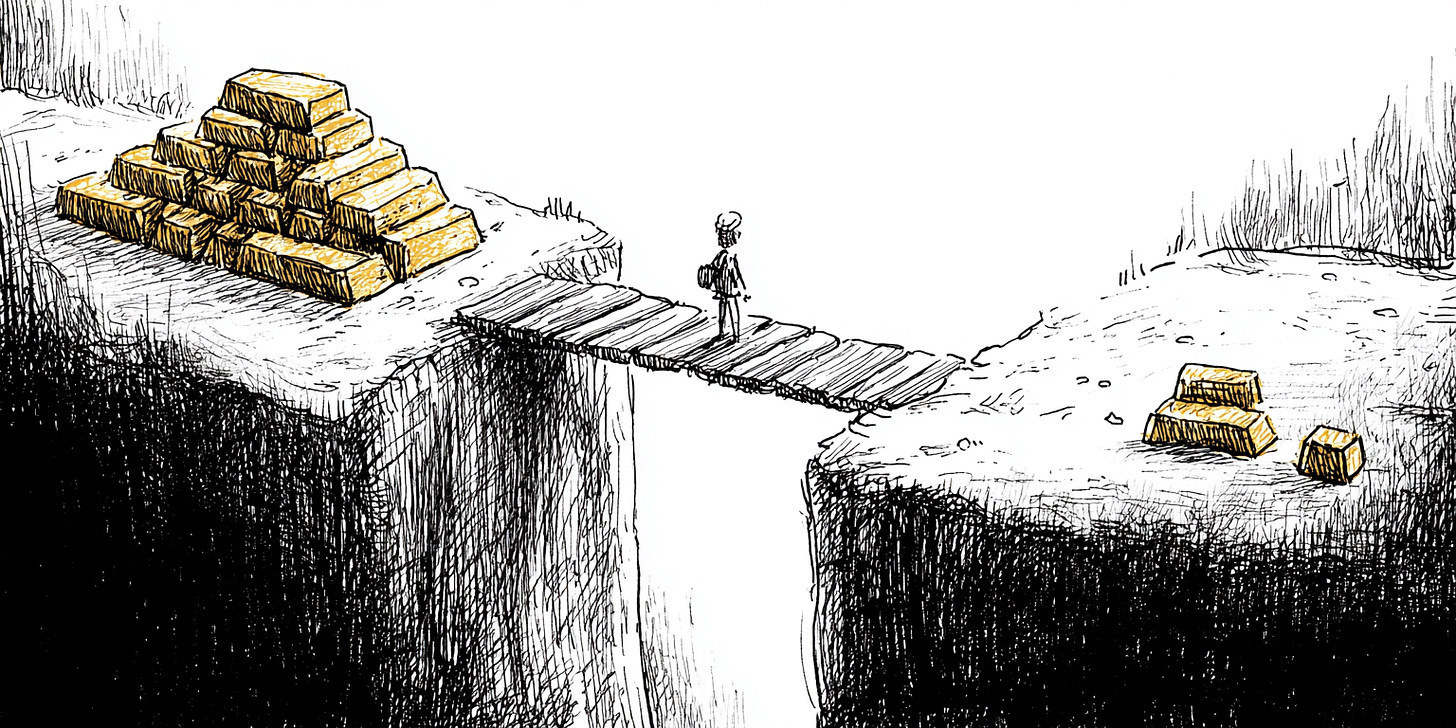

E nesse novo jogo, não é mais sobre quem tem mais recursos.

É sobre quem usa melhor os recursos que tem.

Essa é a lição que a DeepSeek ensinou ao mundo.

Ainda não sei todas as implicações de longo prazo. Ninguém sabe.

Mas uma coisa me parece cada vez mais clara: a pergunta que importa não é “quanto você pode gastar?”

É: você está competindo com escala ou com inteligência?

For those about AI... We salute you.

Caio

PS :: Aproveite o valor da assinatura da minha newsletter VIP por apenas R$19 por mês (ou R$190/ano). Ano que vem o preço irá subir.